CV-Back Propagation

Computing Gradients

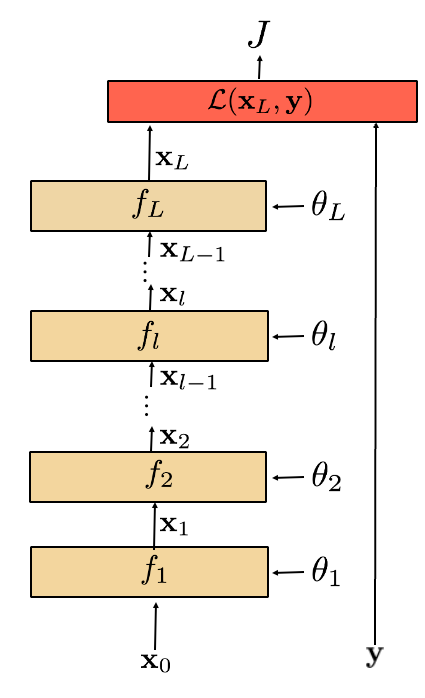

要更新神经网络中某一层的梯度,我们需要基于反向传播(Backpropagation)算法的步骤。这是深度学习中训练神经网络的核心步骤,它可以分为几个主要步骤:前向传播、计算损失、反向传播计算梯度、更新权重。假设我们已经完成了前向传播并计算了损失,现在我们要更新某一层的梯度。以下是详细的步骤:

1. 前向传播计算输出

假设你有一个输入

2. 反向传播计算梯度

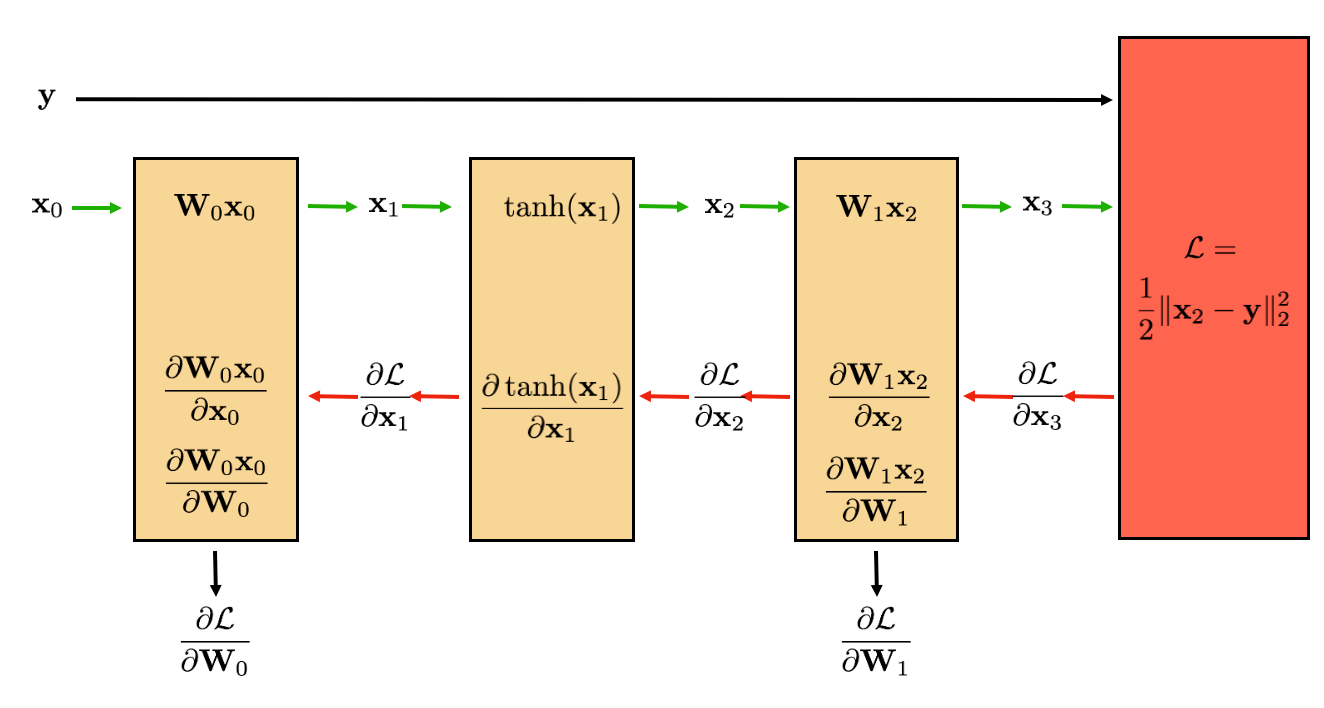

在反向传播中,我们从输出层开始逐层计算梯度,直到到达目标层。这一步的关键是利用链式法则计算每层参数对损失

假设我们有一个中间层

(1) 计算损失对输出的偏导数

首先,我们需要计算损失对这一层输出

(2) 计算损失对权重的偏导数

接下来,我们要计算损失对

如果

所以,最终我们得到:

其中

3. 更新权重

一旦得到了梯度

- 解释:这一公式表示我们沿着损失函数的负梯度方向调整权重,使得损失逐渐减小,从而提高模型的预测准确度。

- 学习率

:学习率控制步长。步长过大可能会错过最优解,步长过小则训练速度较慢。

4. 反复应用上述步骤

反向传播和权重更新的过程会对每一层重复进行,直到所有层的权重都更新完毕。这一轮的梯度计算和更新完成后,模型的权重就得到了调整。然后,我们继续下一轮训练(即下一批数据),重复上述的前向传播、反向传播和更新步骤。

例子:单层的梯度更新

假设你要更新某个中间层

- 首先计算损失对该层输出

的梯度 。 - 然后,利用链式法则,计算该层权重

的梯度 。 - 使用梯度下降更新权重:

。

小结

更新某一层的梯度的关键步骤包括:

- 计算每层输出的梯度。

- 根据每层的输出梯度推导权重的梯度。

- 使用学习率调整权重。

以上就是更新某一层梯度的完整步骤。如果你还有不理解的地方,或者想了解更具体的计算例子,请告诉我!